Форум этики в сфере искусственного интеллекта «Поколение GPT. Красные линИИ»

Источник:

Нейросети всё больше и больше проникают во все сферы нашей жизни – студенты пишут при помощи них эссе, мы можем оплачивать проезд в общественном транспорте, в прямом смысле, своим лицом, генеративные сети встречаются и в сфере искусства, и в политике национальной безопасности отдельных стран. Сейчас неудивительно наличие регулярных обсуждений и разработок в этой области. Таким образом, 16.11 в ТАСС прошёл форум этики в сфере искусственного интеллекта «Поколение GPT. Красные линИИ». Модератором встречи выступил Андрей Незнамов – управляющий директор Центра регулирования ИИ Сбербанка.

Не единожды прозвучавший на конференции Кодекс этики в сфере ИИ был обнародован на пресс-конференции в ТАСС накануне вступления в силу Федерального закона от 31.07.2023 №408-ФЗ (о регулировании рекомендательных технологий), который фактически стал первым нормативным-правовым актом, регулирующим применении ИИ на законодательном уровне.

Началось мероприятие с торжественной церемонии награждения людей и организаций, причастных к развитию IT отрасли. К награде были представлены:

- Уполномоченный по технологиям искусственного интеллекта в Татарстане – Булат Замалиев. Республика Татарстан в принципе первый субъект в нашей стране, взявший на себя разработки в сфере ИИ и примечательно, что именно он лидирует по многим позициям в данном «рейтинге»

- Ханты-Мансийский АО за создание комиссии по ИИ

- В Тюмени и Томске активно вовлекаются органы государственной службы в повестку

- ДВФУ за создание Дальневосточного центра ИИ

- Казанский инновационный университет за кодекс этики в лице Тимура Владимировича Крамина (проректора по корпоративному управлению, директора НИИ, зав. кафедрой финансового менеджмента)

- Университет «Иннополис» – летние школы по робототехнике

- Росатом – разработка и введение принципа ответственного развития ИИ у нас и зарубежом, а также квантовых вычислительных систем – Игорь Скобелев (директор по цифровизации «Русатом Хелскеа» (Росатом))

В целом по стране наблюдается положительная тенденция – 14% компаний и организаций изъявило желание присоединиться к Кодексу этики в сфере ИИ 2021 года, носящий рекомендательный характер (присоединение осуществляется на добровольной основе) и распространяющийся только на гражданские разработки.

Далее в рамках программы форума состоялась дискуссия «Курс развития этики ИИ в России», на которой были представлены работы разных комитетов. От лица рабочей группы по созданию свода наилучших практик решения проблем в области ИИ выступали Елена Сурагина (ведущий юрисконсульт блока по корпоративным и правовым вопросам ПАО «Мобильные ТелеСистемы») и Александр Крайнов (руководитель службы компьютерного зрения и технологий машинного интеллекта Яндекса)

Елена Сурагина: «Нам необходимо было работать не только как коллегам, занятым общим делом, но и сыграться как оркестру, спортивной команде. Могу сказать, что у нас даже не было методологии на решение этических вопросов, поэтому мы создавали её сами, ориентируясь на российские и зарубежные кейсы. В процессе мы выявили несколько траекторий дальнейшей работы. У нас возникла известная в философских учениях проблема вагонетки, которую мы разбирали на примере проекта рекомендаций и принципов разработки беспилотных автомобилей, анализируя международный опыт и руководствуясь интервью российских разработчиков. В данной ситуации встаёт вопрос – чья жизнь ценнее? Сможет ли машина оценить дорожную ситуацию не с позиции математического расчёта, а с моральной точки зрения. Второе направление – цифровые двойники и живых, и не живых людей (акцент, конечно же, делается больше на последних). Обозначилась необходимость систематизации цифровых аватаров и опять же единой системы терминологии. Моменты чисто этические, в том числе касательно умерших родственников как помощников по дому. Третий вектор – вопрос о прозрачности алгоритмов. Необходимо создать проект рекомендаций в сфере прозрачности алгоритмов ИИ и информационных систем на их основе. Методология раскрытия информации нужна для большего доверия со стороны пользователей. Но тут вопрос – какие стороны можно и нужно раскрывать?»

Александр Крайнов: «Генеративный ИИ тренд не только этого года – он долгоиграющий. Однако, количество возникающих проблем всё ещё огромно. Когда мы обсуждали Кодекс этики, решили, что этот вопрос будет «живым». К примеру, если мы используем в работе нейросетей фотографию лица, сделанную в общественном месте, и голос популярного диктора, который также находится в общем доступе. Вроде бы мы здесь и упираемся в авторское право, но с другой стороны, нам это доступно. Поэтому мы пришли к выводу, что все проблемы и решения выдуманы нами самостоятельно. Поэтому мы собираемся каждый раз и решаем возникающий вопрос. Обсуждения, обсуждения, обсуждения. И они необходимы, ведь закон постоянно меняется и будет странно, если этические рекомендации появятся позже него. Но мы должны успевать. Следующий момент – тексты священных писаний, верования – неотъемлемая часть нашей жизни, поэтому тут также возникает немало вопросов. Этично ли использовать ИИ для написания икон, краткого резюме Священных писаний, проведения исповеди? Этично ли при использовании чат-бота для создания иллюзии общения с человеком? Проблем немало и, что касаемо нашей работы в целом, наша роль чисто секретарская и абсолютно администраторская. Все упомянутые выше вопросы берём на себя ответственность отрегулировать за 2024 год».

В рабочую же группу разработки методики оценки рисков входит Анна Абрамова (директор Центра ИИ МГИМО). Она также поддерживает слова Крайнова касательно того, что любая разработка и предложение должны пройти череду дискуссий, чтобы выйти в мир.

Алексей Бырдин – генеральный директор Ассоциации «Интернет-видео», член Экспертного совета Фонда Кино и член рабочей группы по рекомендательным сервисам – говорит о том, что группа сложилась от общего к частному. От законопроекта до нашего быта: онлайн кинотеатры, покупки через интернет – всё, без чего мы не можем сейчас представить нашу жизнь. Поэтому и появилась инициатива по урегулированию этой сферы, а значит, существовали определённые риски. Закон – импульс всей работы, к тому же, в нашей стране он первый, который как-либо затрагивает эту сферу. И, конечно, в дальнейшем их будет больше, поэтому нужно продолжение этого диалога между экспертами и правовыми регуляторами.

Рабочая группа по оценке эффективности реализации кодекса предоставила конкретные результаты своей деятельности:

Что сделано?

- Подготовлены и опубликованы Типовые положения об уполномоченном по этике ИИ и о комитете по этике ИИ для организаций-подписантов Кодекса

- Предложен механизм мониторинга реализации Кодекса участниками, представлена и сама форма мониторинга

- Предложена структура классификации и анализа кейсов этического выбора при использовании ИИ (общие параметры ситуации этического выбора, контекст принятия решения, иерархия приоритетов, варианты действия субъектов Кодекса и т.д.)

Что предстоит?

- Собрать и проанализировать формы мониторинга за 2023 год с подписантами Кодекса

- На основе собранных материалов и кейсов рабочей группы по созданию свода наилучших практик начать обсуждение методических материалов по распознаванию ситуаций этического выбора («красные флажки»)

- Порядок действий по неполному соответствию подписанного кодекса

В конце оживлённой дискуссии из зала последовал весьма интересный вопрос – слушатель представился как журналист-международник и поинтересовался, как работать с дипфейками в журналистике, ведь ИИ может с лёгкостью их воспроизводить в огромном количестве. Здесь подчёркивается связь ИИ, журналистики и политики.

Удар на себя принял Крайнов. Он отослался к тому же Кодексу и привёл пример с Илоном Маском, поющим песню «Земля в иллюминаторе». Можно ли делать любого рода фейки с использованием нейросетей? Конечно нет! Но встаёт вопрос о пародиях. С одной стороны, это вполне нормально, ведь это больше относится к сфере искусства и юмора. Но и это можно завернуть в дипфейк. Вроде бы, все понимают, что это шутка, но это же введение в заблуждение. Так что вопрос спорный. Он также сравнил этику ИИ с прокладыванием асфальта по уже протоптанной дороге – ориентируясь на конкретные прецеденты, происходит дальнейшая кодификация существующей практики. Однако кодекс – это нечто верхнеуровневое, на мероприятиях подобного масштаба (как рассматриваемый форум) происходят просто обсуждения и разработка возможных стратегий работы.

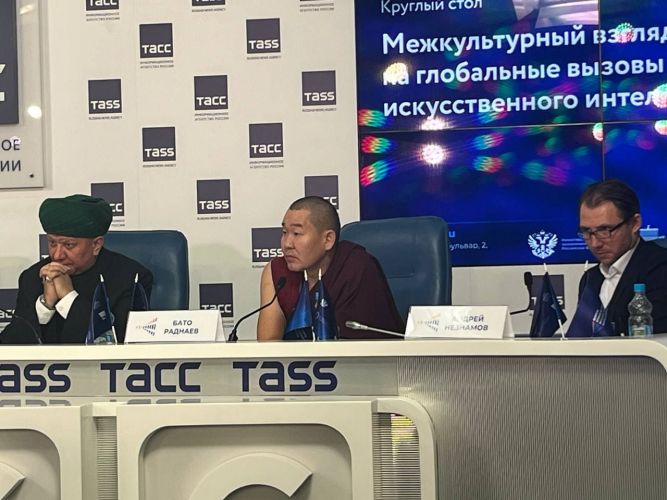

Одной из самых интересных частей программы был разговор с представителями различных конфессий, существующих в нашей стране – круглый стол «Межкультурный взгляд на глобальные вызовы развития искусственного интеллекта».

Муфтий Альбир Крганов (глава муфтий ЦРО «Духовного собрания мусульман России») заявил, что наука должна использоваться во благо, как милость божья. Ресурсы должны быть распределены правильно для нашего блага. Но важнейшим моментом здесь является вопрос о цифровом бессмертии – происходит эволюция трансгуманистических идей. Смерть – неотъемлемая часть жизни человека. В сложившейся ситуации мы имеем возможность жить после биологической смерти при переносе сознания в компьютер. Проблема смерти в биологическом аспекте просто исчезает, и мы вынуждены искать баланс между восприятием человеческой жизни и стремлением к вечному. Мы имеем дело с дискредитацией сложившейся системы традиционных духовно-нравственных ценностей. Но не ясно, в чьих же руках находится то самое цифровое бессмертие, кто обладает данными? Вопрос о приватности, да и необходимо сохранять какое-то уважение к умершему. Муфтий подытоживает, что нам открылись новые, куда большие возможности, но на наши плечи лёг дополнительный груз ответственности. «Мы не против науки, если это действительно во благо человека».

Владимир Легойда – российский церковный и общественный деятель, журналист, педагог, специалист в области культурологии, политологии и религиоведения, кандидат политических наук, доцент – выступал сразу после. Он убеждён, что развитие науки и ИИ – вещь необратимая, но нужно разработать свою новую философию. Фундаментальной характеристикой науки является внеморальность. Этическое измерение возможно, когда мы хотим получить научные данные (выявляем красные линии, табу) и когда применяем полученные результаты научной деятельности на практике. Вопрос о том, как мы используем научный продукт и для чего, то есть в целеполагании. Техника расширила горизонты, но в терминах Лотмана не стала культурой. Речь идёт о том, что мы приобретаем что-то принципиально новое, ещё не разобравшись с функциями предыдущего в полной мере. Пример с точкой в конце сообщения, которая в глазах более молодого поколения приобретает негативную коннотацию. Эксперт приводит также аналогию с фильмом «Инкогнито». По его мнению, ИИ просто имитирует заданную манеру. Получается «слишком похоже» на автора – нейросеть просто вбирает в себя всё и повторяет так, как должен был сделать условный Рембрандт, но настоящий бы никогда не повторился. Также, по мнению учёного, висит угроза «очеловечивания» ИИ для людей, работающих в рамках алгоритмов – т.е. для коучей. Для развивающихся людей, читающих Библию, Коран, философию и пр. угроз нет – там их никто не заменит. Генерация смыслов всё равно остаётся за человеком.

Александр Волков (священник, алтарник храма святой мученицы Татианы при МГУ имени М.В. Ломоносова): «Если бы темы этики не было, мы были бы больны. Поэтому частота подобных обсуждений – здоровый индикатор. Этика без религии будто бы искусственна. Именно религиозное измерение этических основ должно быть. Важно помнить о целях и смыслах, а не только стремиться к развитию. Если будем активно стремиться к прогрессу ради человека, то от самого человека может не остаться ничего. Человек должен иметь право на ошибку и на творчество – ИИ может это уничтожить, а это важнейшие постулаты». Далее последовал вполне логичный вопрос – что же делать разработчику? Отец Александр считает, что необходимо введение некоторых ограничений, пока это возможно сделать.

Бато Раднаев (бурятский религиозный деятель) указывает на неразрывную связь науки и буддизма на протяжении всей истории: использование дедуктивной логики обеими сторонами, применение изобретений буддистов в Великой Отечественной войне, знания буддистов в области природы, философии, медицины и преемственность науки в этом вопросе и т.д. Всё это может помочь в усовершенствовании нейросетей. Интеллект, по мнению Раднаева, это больше про ментальность. «Стремление к жизни – интеллект, стремление к духовному развитию – это тоже интеллект. У ментальности разные качества – и это всё интеллект. Он способен развивать каждое качество из них».

Далее обсуждение разделилось на два трека, в одном из которых обсуждалось этико-гуманитарное измерение ИИ, другой имел более техническую направленность. В рамках первого были затронуты такие темы, как взращивание новых кадров, ответственных за вектор развития ИИ, безопасность человека и гражданина в информационную эпоху и прочие опасения экспертов и простых пользователей. В дискуссии участвовали А.Крайнов, К.Абрамов (ВЦИОМ), А.Горобец (Минпросвещения России), А.Ткачёв (Государственная дума), И.Илларионов (ГК Самолёт), А.Аветисян (ИСП РАН), Д.Земцов (ВШЭ), К.Воронцов (институт ИИ МГУ), А.Наумов (ВШЭ), Д.Чирва (ИТМО)

79% россиян считают, что нужно участие человека в деятельности ИИ, когда мы касаемся вопросов этичности. Респонденты считают, что ИИ сложнее всего сочетать в сфере государственного управления, медицины и в военном деле. Нейросеть здесь попросту не выдерживает этические нормы – они везде разные, а если сверху на них наложить закон, то проблем будет ещё больше, считают участники круглого стола.

Необходимы междисциплинарные исследования – нельзя кому-то одному декларативно написать. Важен учёт мнения и законотворцев, и социологов, и технологов и прочих. Дарья Чирва, как преподаватель философских дисциплин для технических специальностей в ИТМО, заявляет о важности умения строить диалог в этом вопросе. По ее словам, работа идет с нормативно-ценностными суждениями. Это не алгоритм, а определённый способ мышления.

Соответственно, также встаёт вопрос касательно того, какие критерии мы можем вывести для того самого «коллективного органа людей», ответственных за дальнейшее развитие ИИ.